คู่แข่งที่น่ากลัวที่สุดของ NVIDIA ในโลกชิป AI ตอนนี้ ไม่ใช่ AMD หรือ Intel — แต่คือ Google ที่กำลังเร่งเครื่องเข้ามาอย่างรวดเร็ว และที่น่าสนใจคือ Jensen Huang ซีอีโอของ NVIDIA เองก็รู้เรื่องนี้ดีอยู่แล้ว

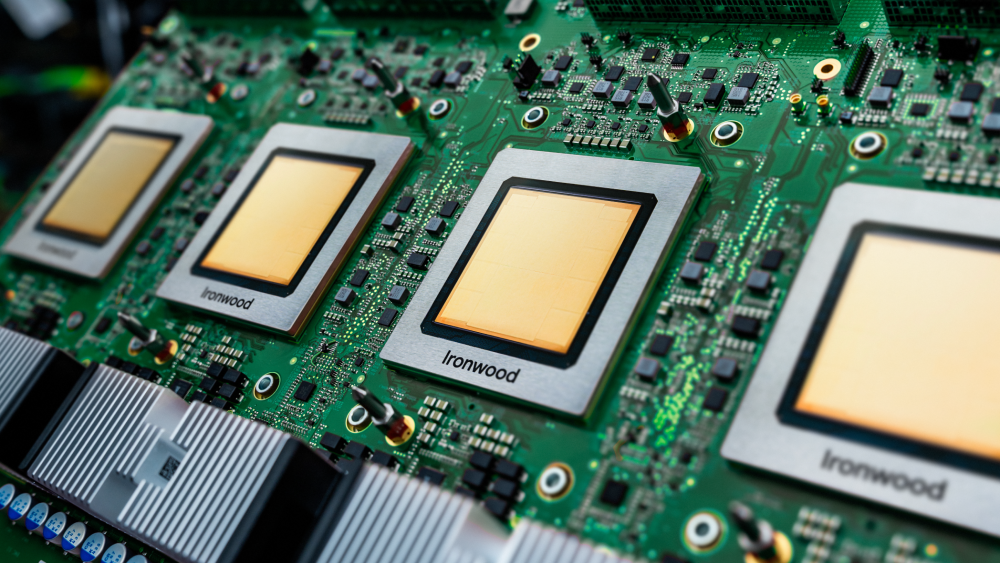

ฟังดูอาจแปลกใจเล็กน้อย แต่จริง ๆ แล้ว Google ถือเป็นผู้เล่นรายแรก ๆ ในสมรภูมิชิป AI เพราะเปิดตัวชิป TPU (Tensor Processing Unit) รุ่นแรกตั้งแต่ปี 2016 — ก่อนทั้ง AMD, NVIDIA และ Intel เสียอีก ล่าสุดเมื่อสัปดาห์ที่แล้ว Google ได้เปิดตัวชิป TPU รุ่นที่ 7 (Ironwood) ซึ่งสร้างความฮือฮาในวงการอย่างมาก และทำให้ “ศึก NVIDIA vs Google” กลายเป็นคู่แข่งที่แท้จริงของยุคนี้

Google Ironwood TPU: พลังมหาศาล พร้อม HBM ขนาด 192GB

TPU รุ่น Ironwood (v7) เป็นชิปที่ออกแบบมาเพื่อ งานประมวลผลแบบ Inference (การอนุมาน) โดยเฉพาะ ซึ่งถือเป็นยุคใหม่ของ AI ที่ตลาดกำลังขยับจาก “การเทรนโมเดล” มาสู่ “การให้โมเดลทำงานจริง”

สเปกเด่นของ Ironwood:

-

ประสิทธิภาพสูงกว่า TPU v5p ถึง 10 เท่า

-

ดีกว่า TPU v6e (Trillium) ถึง 4 เท่า ทั้งด้าน Training และ Inference

-

ใช้หน่วยความจำ HBM 192GB แบนด์วิดท์ 7.4 TB/s

-

พลังประมวลผลสูงสุด 4,614 TFLOPs ต่อชิป — มากกว่า TPUv4 ถึง 16 เท่า

-

แต่ละ SuperPod รวมชิปได้ 9,216 ตัว ให้พลังรวม 42.5 ExaFLOPS (FP8)

-

ระบบเชื่อมต่อระหว่างชิป InterChip Interconnect (ICI) มีประสิทธิภาพเหนือกว่า NVLink ของ NVIDIA

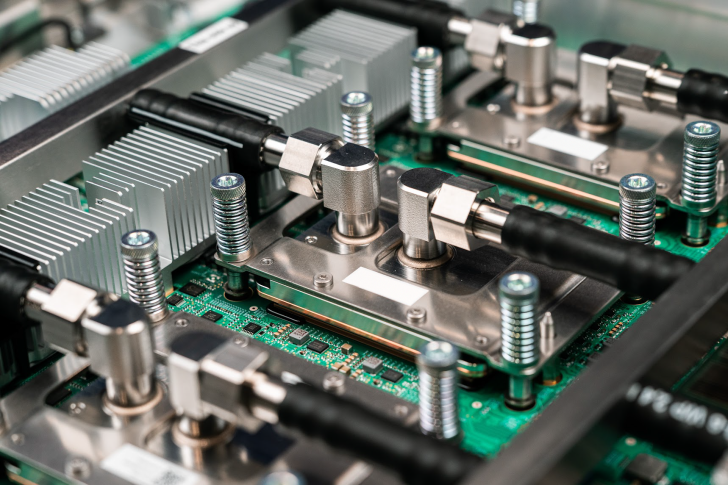

Google ใช้สถาปัตยกรรม 3D Torus ในการเชื่อมต่อเครือข่ายระหว่าง TPU จำนวนมาก ทำให้ระบบขยายขนาดได้มหาศาลและลดคอขวดในการประมวลผล ซึ่งเป็นจุดแข็งที่ทำให้ SuperPod ของ Google ถูกมองว่า “เหนือกว่า” ด้าน scalability

ทำไม Ironwood ถึงเป็นภัยคุกคามต่อ NVIDIA?

ตลอดหลายปีที่ผ่านมา NVIDIA ครองตลาด AI Training ด้วย GPU ระดับเทพอย่าง H100 และ B200 แต่พอโลกเริ่มเข้าสู่ยุค “Inference” ที่เน้นให้โมเดลตอบคำถามหรือทำงานจริงแบบเรียลไทม์ เกมกลับเริ่มเปลี่ยน

ในงาน Inference ปัจจัยสำคัญไม่ได้มีแค่ “TFLOPs เยอะ” อีกต่อไป แต่คือ ความหน่วงต่ำ (latency), ปริมาณคำตอบต่อวินาที (throughput), ประสิทธิภาพพลังงาน (efficiency) และ ต้นทุนต่อการประมวลผลหนึ่งครั้ง (cost per query) — ซึ่ง Ironwood ของ Google ทำได้โดดเด่นในทุกด้าน

ชิป Ironwood ยังมาพร้อมหน่วยความจำขนาดใหญ่มาก ซึ่งช่วยลดการสื่อสารระหว่างชิปและลดความหน่วงได้ดี เหมาะกับโมเดลใหญ่ ๆ อย่าง LLMs ที่ต้องทำงานต่อเนื่องตลอด 24 ชั่วโมง

Google ยังเคลมว่า Ironwood มี ประสิทธิภาพด้านพลังงานดีกว่ารุ่นก่อน 2 เท่า ทำให้เหมาะสำหรับศูนย์ข้อมูลระดับ Hyperscale ที่ต้องรันงาน inference หลายพันคำสั่งพร้อมกันตลอดเวลา

กล่าวอีกอย่างคือ ศึก AI จากนี้จะเปลี่ยนจาก “ใครแรงกว่า” เป็น “ใครตอบได้เร็วกว่า ถูกกว่า และใช้พลังงานน้อยกว่า” — และนี่คือแนวรบใหม่ที่ Google กำลังรุกเข้าใส่ NVIDIA โดยตรง

Ecosystem Lock-In: จุดแข็งของ Google Cloud

Ironwood จะถูกให้บริการเฉพาะใน Google Cloud เท่านั้น หมายความว่าลูกค้าที่เลือกใช้ TPU จะถูกผูกไว้กับ ecosystem ของ Google ซึ่งอาจกลายเป็น “อาวุธลับ” ที่ท้าทายการครองตลาดของ NVIDIA ในระยะยาว

ปัจจุบัน Google พัฒนา TPU มาถึงรุ่นที่ 7 แล้ว ขณะที่ NVIDIA กำลังเตรียมเปิดตัวสถาปัตยกรรม Rubin CPX เพื่อรับมือยุค Inference เช่นกัน แต่ในแง่ของการขยายระบบและพลังประมวลผลเฉพาะทาง — Google กำลังกลายเป็นคู่แข่งที่ น่ากลัวจริง ๆ

Jensen Huang เองเคยพูดถึง TPU ไว้ในพอดแคสต์ BG2 ว่า:

“Google เริ่มทำ TPU1 ตั้งแต่ก่อนที่ทุกอย่างจะเริ่มต้นด้วยซ้ำ … การสร้างชิป ASIC แบบนี้เป็นงานที่ยากมาก — และ Google ก็ทำได้ดีมาก”

สรุป:

-

ศึก AI กำลังเปลี่ยนจาก “Training GPU War” ไปเป็น “Inference Efficiency War”

-

Google TPU Ironwood คือคู่แข่งโดยตรงของ NVIDIA Blackwell

-

การรุกของ Google ในตลาด Cloud + AI Hardware อาจสั่นคลอนอำนาจของ NVIDIA ครั้งใหญ่ในอีกไม่กี่ปีข้างหน้า

การแข่งขันนี้ไม่ใช่แค่เรื่องของความแรงอีกต่อไป — แต่มันคือ “สงครามของความคุ้มค่าและพลังประสิทธิภาพ” ระหว่างสองยักษ์ใหญ่แห่งยุค AI: NVIDIA vs Google

ที่มา: Wccftech