ที่งาน Hot Chips 2025 AMD ได้ประกาศเปิดตัวรายละเอียดสถาปัตยกรรมเต็มรูปแบบของ Instinct MI350 Series การ์ดเร่งความเร็วด้าน AI รุ่นใหม่ล่าสุด ซึ่งถือเป็นโซลูชันเรือธงสำหรับงาน AI โดยเฉพาะ มุ่งพัฒนาศักยภาพในการ เทรนและประมวลผล (Inference) โมเดลภาษาขนาดใหญ่ (LLMs)

ไฮไลท์ของ MI350 Series

-

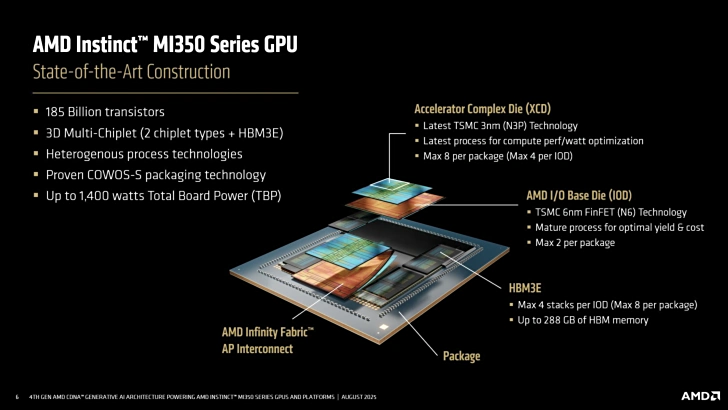

สถาปัตยกรรมใหม่ CDNA 4 บนเทคโนโลยี 3nm

-

ดีไซน์ 3D multi-chiplet รวม 185 พันล้านทรานซิสเตอร์

-

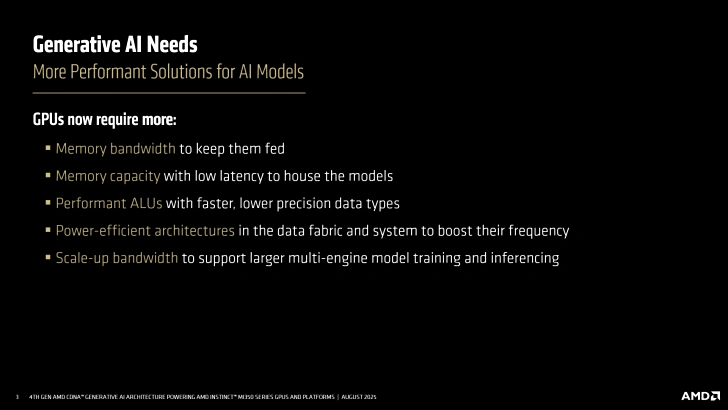

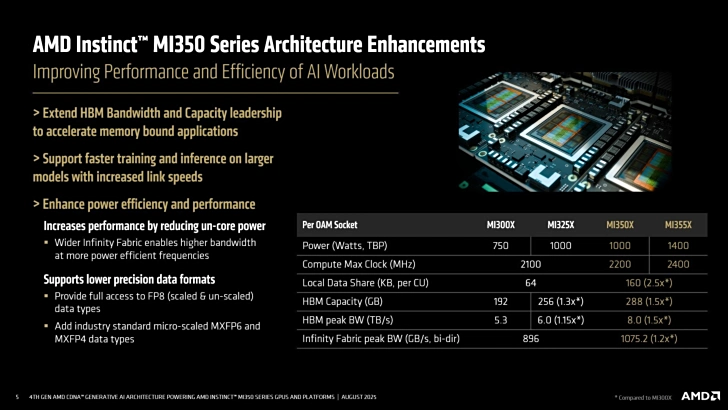

มาพร้อม หน่วยความจำ HBM3e ขนาด 288GB แบนด์วิดท์สูงสุด 8TB/s ต่อการ์ด

-

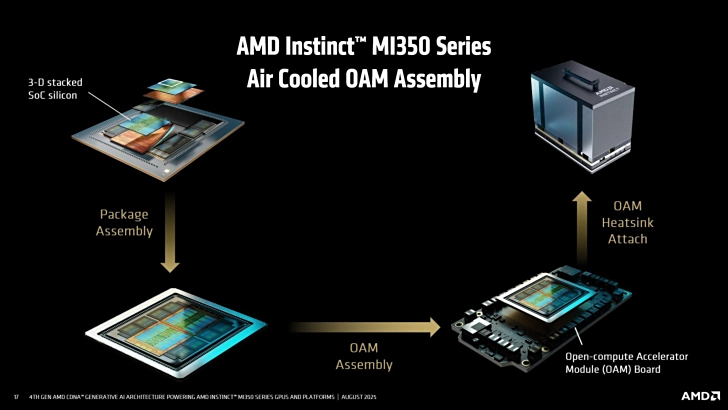

มีทั้งรุ่น MI350X (Air-cooled) TDP 1000W ความถี่สูงสุด 2.2GHz และ MI355X (Liquid-cooled) TDP 1400W ความถี่สูงสุด 2.4GHz

โครงสร้างหลัก

-

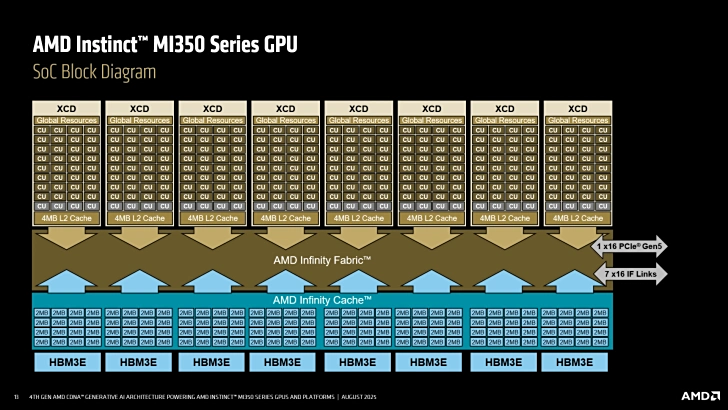

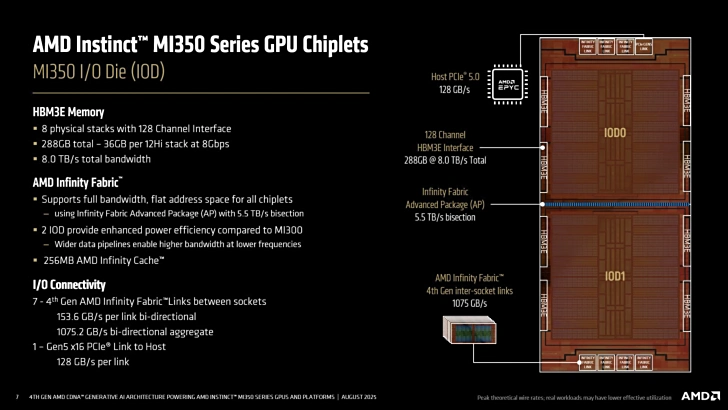

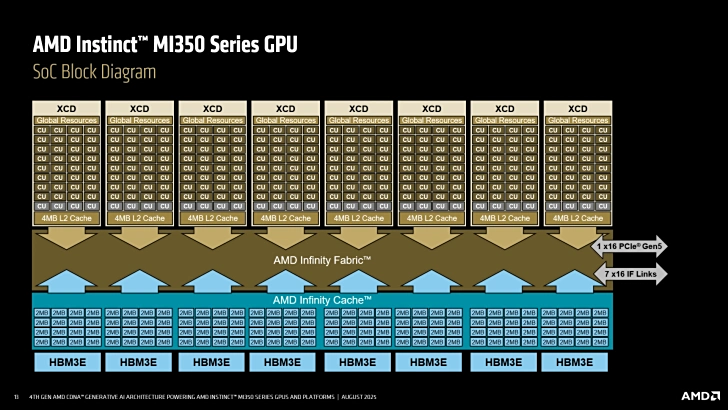

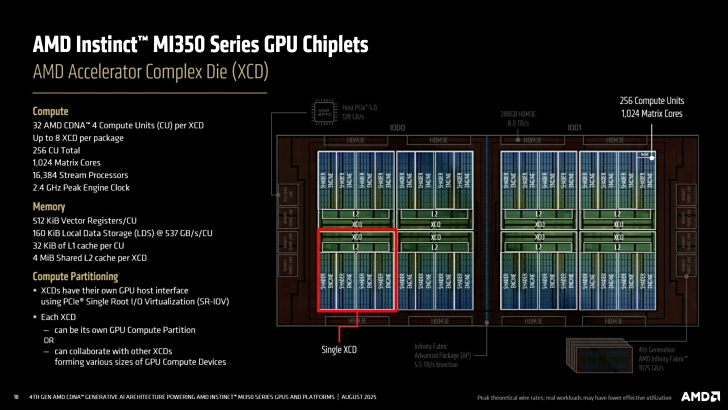

ใช้ 8 XCDs (คอร์ประมวลผล) + 2 IODs (คอร์ IO)

-

เชื่อมต่อด้วย Infinity Fabric Gen 4 แบนด์วิดธ์สองทางสูงสุด 1075GB/s

-

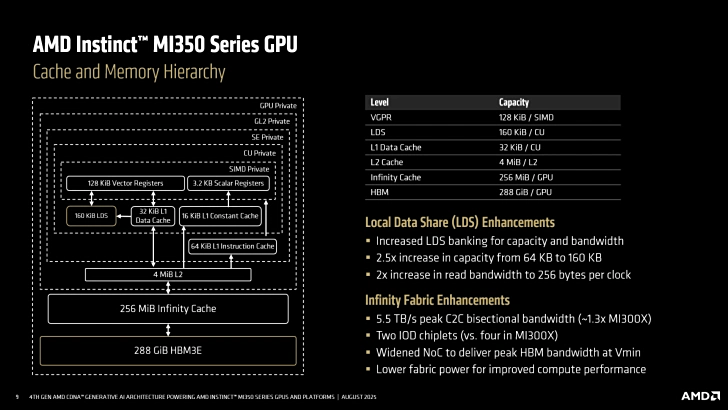

มี Infinity Cache 256MB

-

คอนโทรลเลอร์ HBM3e รองรับ โมดูล 36GB จำนวน 8 ชิป รวมเป็น 288GB

หน่วยประมวลผล

-

256 CUs รวมทั้งหมด 16,384 Stream Processors + 1,024 Matrix Cores

-

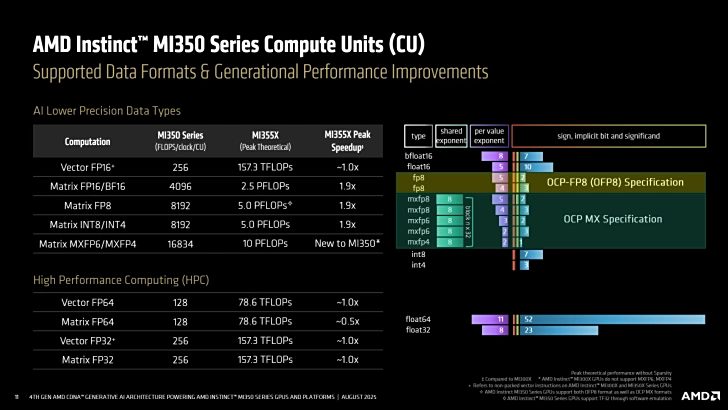

รองรับการประมวลผลหลายระดับ เช่น FP8, MXFP6/MXFP4, INT8/INT4

-

FP4/FP6 Computing Power สูงสุด 20 PFLOPs

-

FP8 Computing Power สูงสุด 80.5 PFLOPs

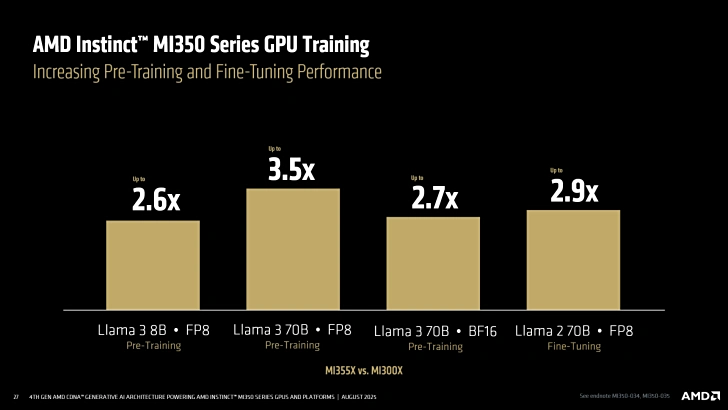

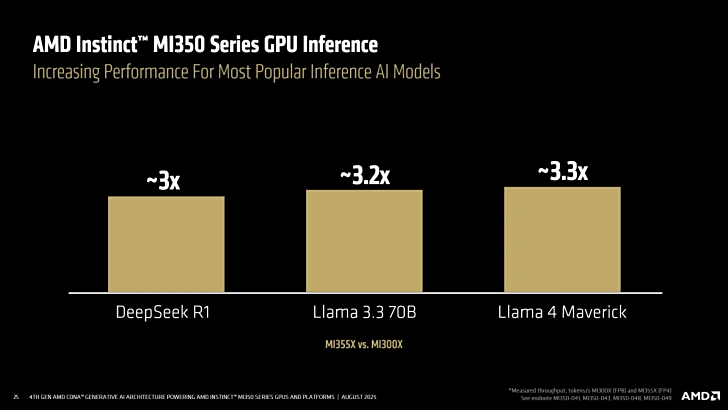

ประสิทธิภาพ AI

-

เร็วกว่ารุ่นก่อน (MI300 Series) อย่างชัดเจน

-

Inference Llama 3.1 405B ดีขึ้นสูงสุด 35 เท่า

-

Inference Deepseek R1 ดีขึ้น 3 เท่า

-

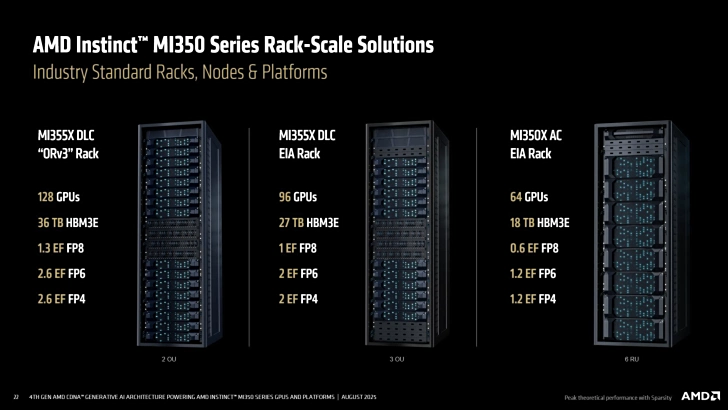

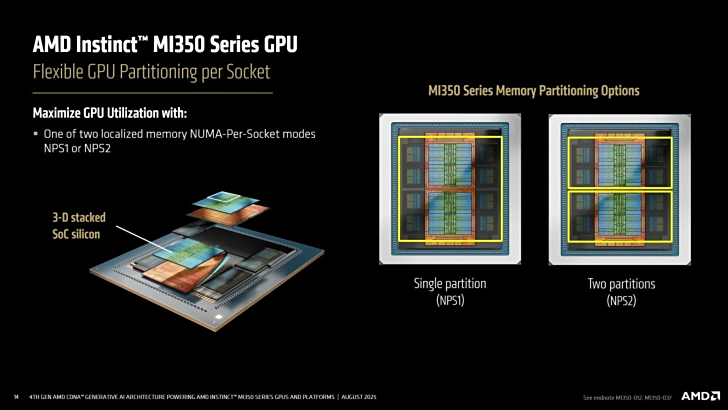

การขยายระบบ

-

รองรับ Partition GPU/VRAM ตามต้องการ

-

การ์ดเดียวสามารถรัน โมเดลขนาด 70B parameters ได้สูงสุด 8 instances

-

เชื่อมต่อหลายการ์ดผ่าน ลิงก์สองทาง 154GB/s

-

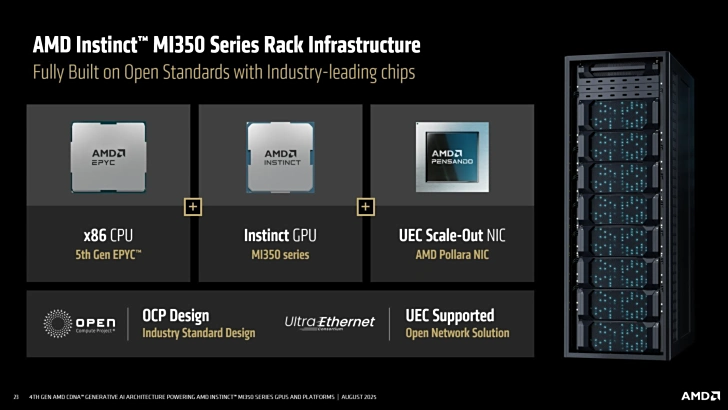

ใช้แพ็กเกจ OAM มาตรฐาน ติดตั้งบน UBB 2.0 backplane

-

ระบบ 8 การ์ด สามารถจับคู่กับ EPYC Gen 5 + 400GbE NIC เพื่อใช้งานในดาต้าเซ็นเตอร์

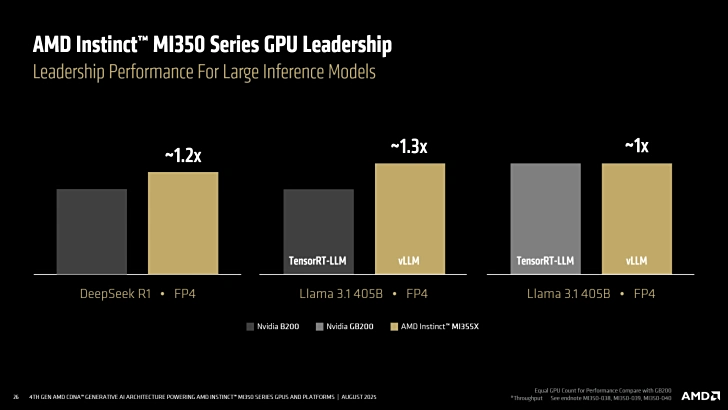

เทียบกับคู่แข่ง (NVIDIA GB200/B200)

-

MI355X แรงกว่า

-

FP6/FP64 มากกว่า 2 เท่า

-

HBM Capacity มากกว่า 1.6 เท่า

-

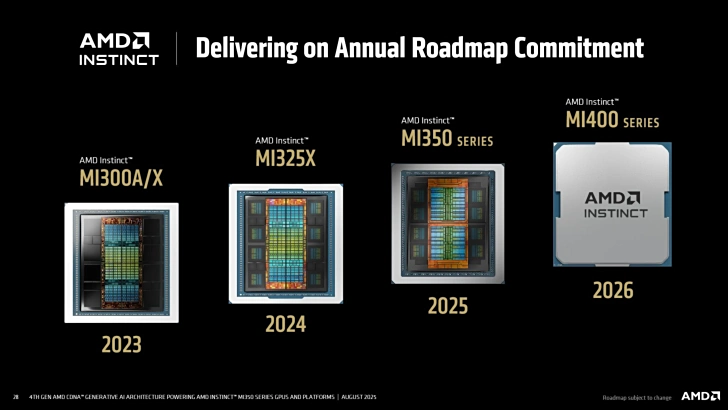

การวางจำหน่าย

-

จะพร้อมจำหน่ายผ่านพาร์ทเนอร์ใน ไตรมาส 3 ปี 2025

-

AMD ยืนยันว่าได้เริ่มพัฒนา MI400 Series แล้ว โดยตั้งเป้าวางขายในปี 2026

ที่มา : IT Home