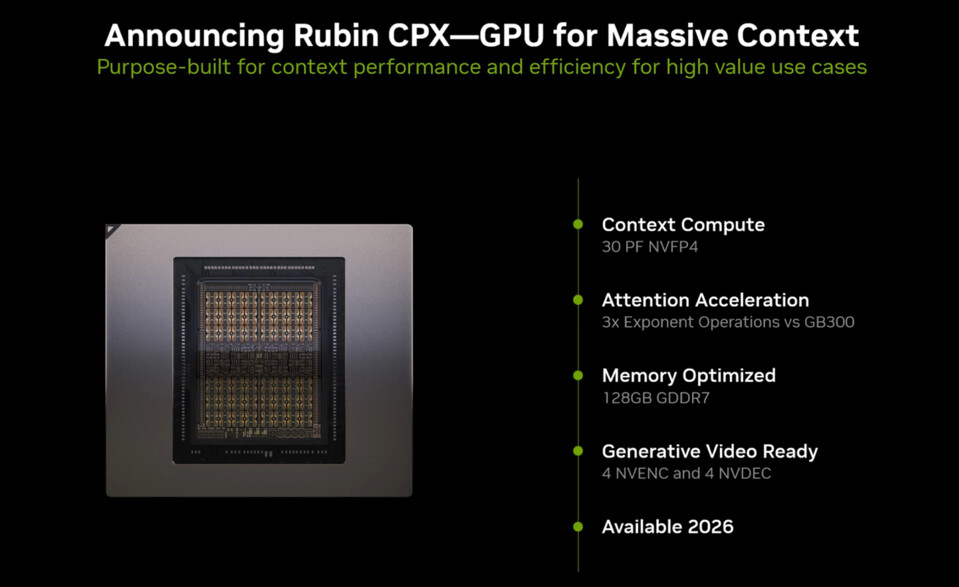

ระหว่างงาน AI Infra Summit ทาง NVIDIA ได้ประกาศเปิดตัว “Rubin CPX” GPU ซึ่งเป็นตัวเร่งพิเศษ (specialized accelerator) ที่พัฒนาขึ้นจากตระกูล “Rubin” รุ่นใหม่ โดยออกแบบมาเฉพาะสำหรับ AI โมเดลที่ต้องใช้ context ขนาดมหาศาล

ชิปนี้สามารถทำประสิทธิภาพการประมวลผล 30 PetaFLOPS (NVFP4) บน ชิปเดี่ยว (monolithic die) มาพร้อมหน่วยความจำ GDDR7 ขนาด 128 GB จุดที่โดดเด่นคือ การเลือกใช้ ดีไซน์ชิปเดี่ยว แตกต่างจากสถาปัตยกรรม Blackwell / Blackwell Ultra ที่ใช้แพ็กเกจ GPU แบบคู่ และยังต่างจาก Rubin รุ่นอื่นที่จะออกตามมาในอนาคต

Rubin CPX ถูกออกแบบมาเพื่อแก้ปัญหาคอขวดของการประมวลผลในงาน extended-context AI ที่ต้องจัดการ หลายล้านโทเคนพร้อมกัน เช่น

-

การวิเคราะห์โค้ดซอฟต์แวร์ทั้ง codebase

-

การประมวลผลวิดีโอความยาวชั่วโมง ซึ่งอาจต้องใช้โทเคนมากกว่า 1 ล้านโทเคน

ภายในตัวชิปยังบรรจุ 4 NVENC + 4 NVDEC encoder/decoder สำหรับวิดีโอ ทำให้รองรับ workflow ด้านมัลติมีเดียได้โดยไม่ต้องพึ่งพาตัวประมวลผลภายนอก

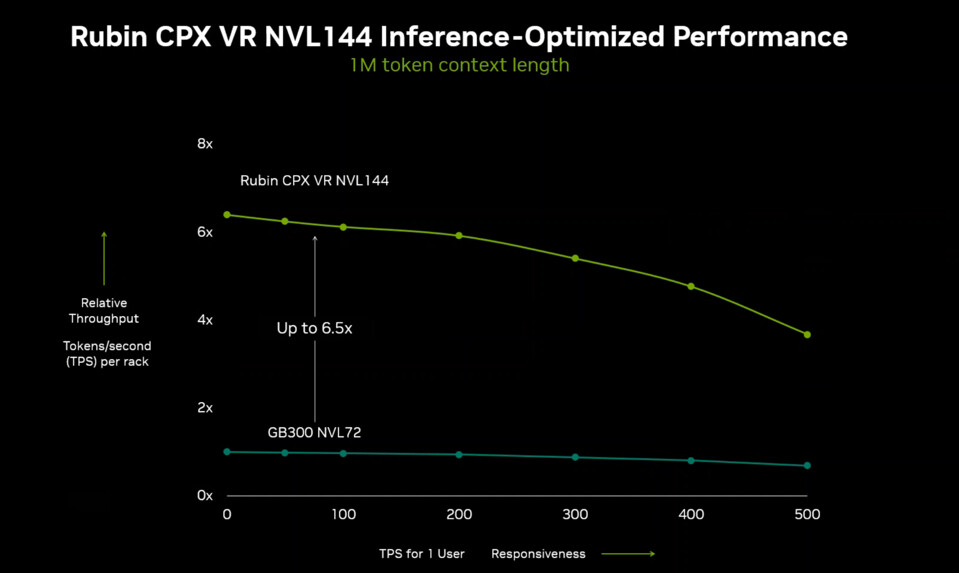

ด้านประสิทธิภาพ Rubin CPX ทำความเร็วได้ดีกว่า GB300 Blackwell Ultra ถึง 3 เท่า ในการประมวลผล attention ข้อมูลจำนวนมาก โดยเลือกใช้ สถาปัตยกรรมชิปเดี่ยวแบบ cost-optimized เพื่อลดความซับซ้อนในการผลิต แต่ยังคงความหนาแน่นในการประมวลผลสูง แม้ยังไม่เปิดเผยสเปกแบนด์วิดท์หน่วยความจำ แต่หากใช้บัส 512-bit และชิป GDDR7 30 Gbps จะทำ throughput ได้ราว 1.8 TB/s

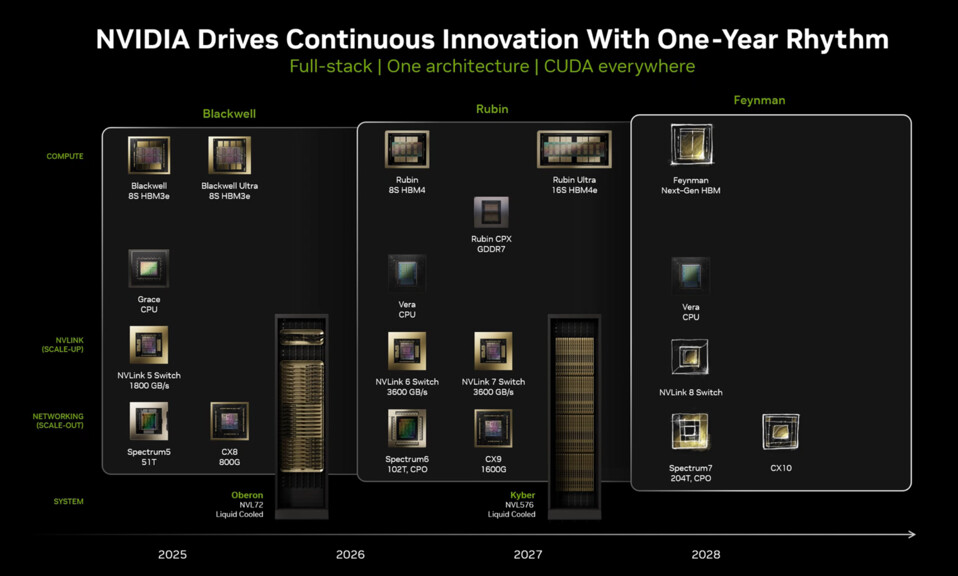

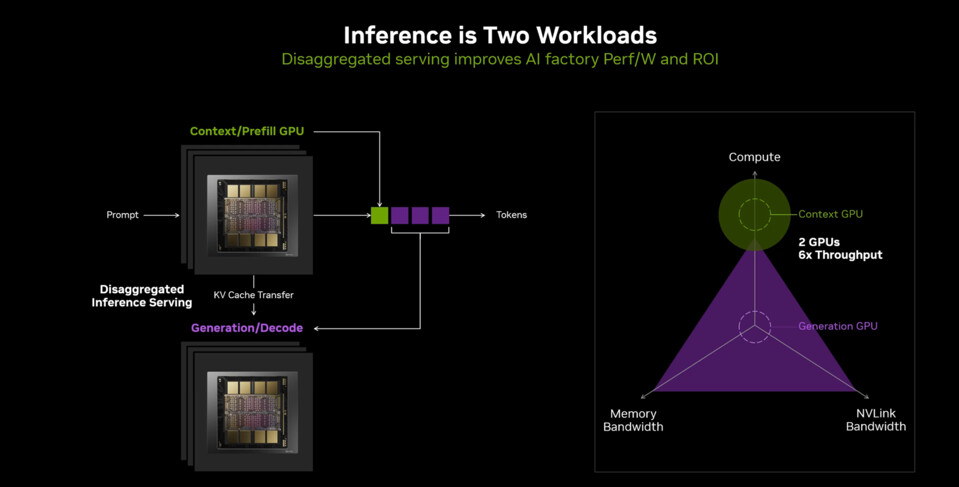

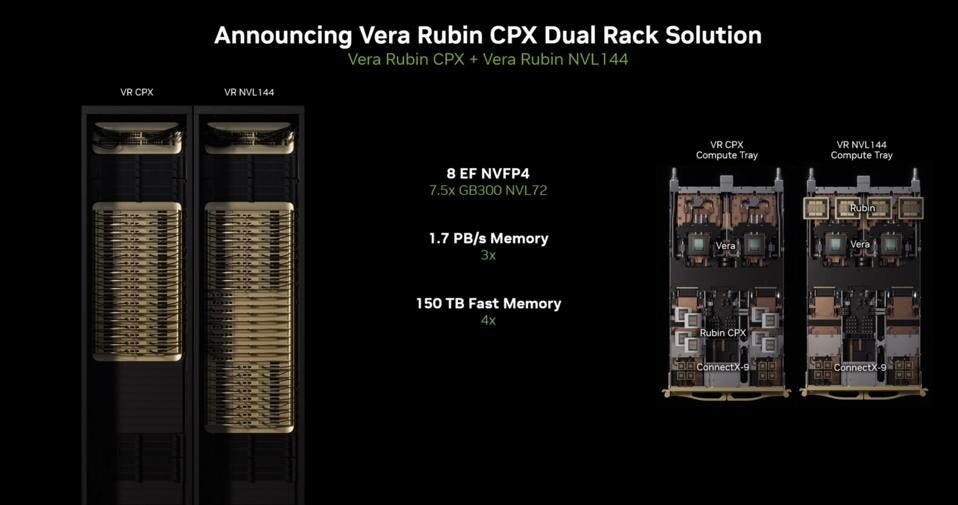

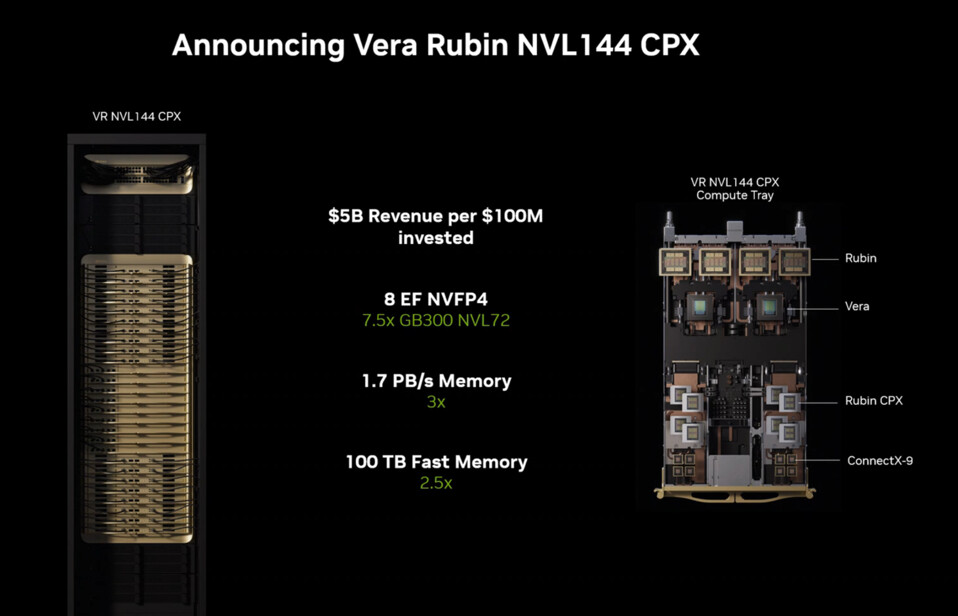

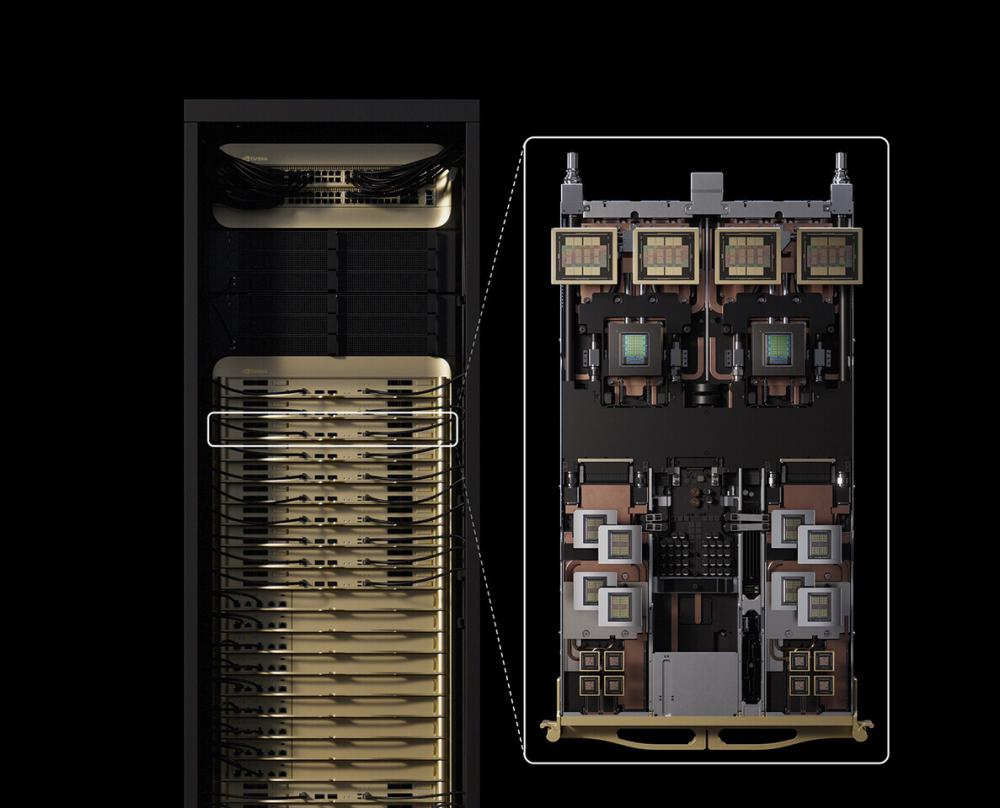

NVIDIA เตรียมนำ Rubin CPX ไปใช้งานในแพลตฟอร์ม Vera Rubin NVL144 CPX ที่ผสมผสาน GPU Rubin รุ่นหลักกับรุ่น CPX แบบพิเศษ เพื่อสร้างกำลังประมวลผลรวมถึง 8 ExaFLOPS และ แบนด์วิดท์หน่วยความจำ 1.7 PB/s ต่อหนึ่งแร็กเต็มชุด โดย Kyber Rack จะมาพร้อมอุปกรณ์เครือข่าย ConnectX-9 รองรับ 1600G, สวิตช์ Spectrum6 ทำความเร็ว 102.4T และ optics แบบ co-packaged มีกำหนดเปิดตัวปลายปี 2026 (หลังจาก GPU Rubin รุ่นปกติซึ่งจะมาก่อนในต้นปี 2026)

สำหรับ Rubin CPX นั้น NVIDIA วางตำแหน่งเป็น “รุ่นพิเศษ” ของตระกูล Rubin ที่ออกแบบเพื่อรองรับ AI inference ยุคใหม่ ซึ่งซับซ้อนกว่าการสร้างข้อความธรรมดา แต่ต้องใช้ reasoning หลายขั้นตอน และ persistent memory ในการโต้ตอบยาวนาน เช่น chatbot ที่รองรับ 256,000 โทเคน ต่อ session หรือการวิเคราะห์โค้ดยาวกว่า 100,000 บรรทัด

สรุปคือ Rubin CPX ถูกสร้างมาเพื่อเป็น ฮาร์ดแวร์เฉพาะทาง ที่ทำให้การทำงานของ AI รุ่นถัดไป “ไร้รอยต่อ” มากขึ้นสำหรับนักพัฒนา โดยเฉพาะเมื่อโลก AI กำลังเปลี่ยนจาก โมเดลภาษา (LLMs) ไปสู่ ระบบเหตุผลขั้นสูง (reasoning agents) ที่ต้องใช้ทั้งกำลังคำนวณและแบนด์วิดท์หน่วยความจำจำนวนมหาศาล

ที่มา : TechPowerUp