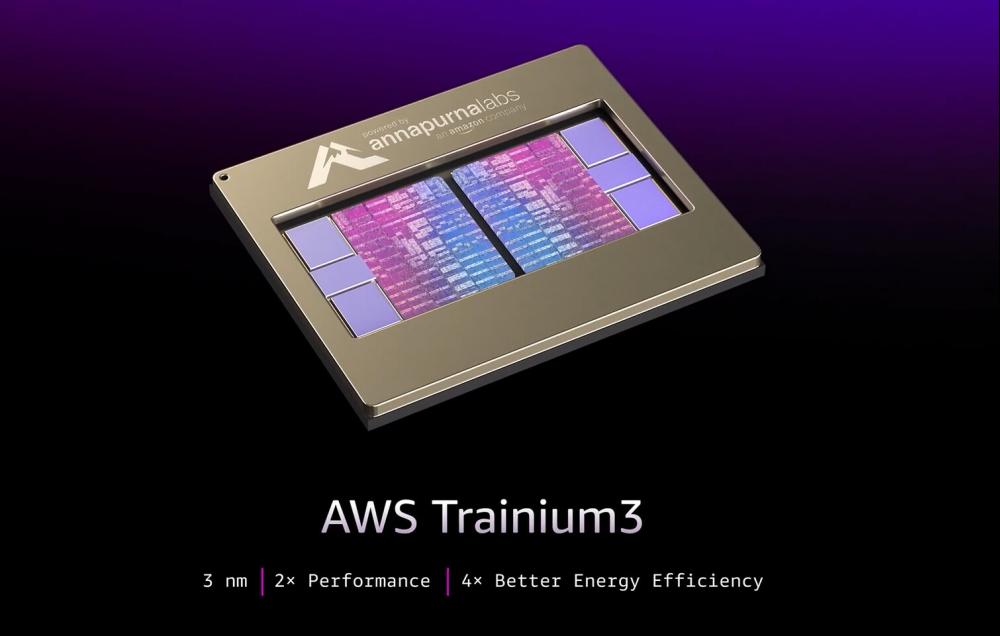

ในงาน re:Invent ที่ลาสเวกัส AWS ได้เปิดตัวชิป ASIC รุ่นใหม่ Trainium3 ซึ่งออกแบบมาสำหรับงานประมวลผล AI ภายในบริษัท และลูกค้าภายนอกบางส่วน ชิปนี้ให้ประสิทธิภาพ FP8 สูงถึง 2.52 PetaFLOPS ต่อชิป พร้อมอัปเกรดหน่วยความจำบนชิปเป็น 144 GB HBM3E ที่มีแบนด์วิดท์ 4.9 TB/s Trainium3 รองรับทั้งโมเดลแบบ dense และ expert-parallel รวมถึงมีชนิดข้อมูลใหม่อย่าง MXFP8 และ MXFP4 เพื่อเพิ่มความสมดุลระหว่างหน่วยความจำและการประมวลผลสำหรับงานเรียลไทม์ มัลติโมดัล และงาน reasoning แบบ context ยาว ชิปถูกผลิตด้วยเทคโนโลยี TSMC 3 nm (N3) และพร้อมให้ใช้งานแล้วบนอินสแตนซ์ Amazon EC2 Trn3 UltraServer

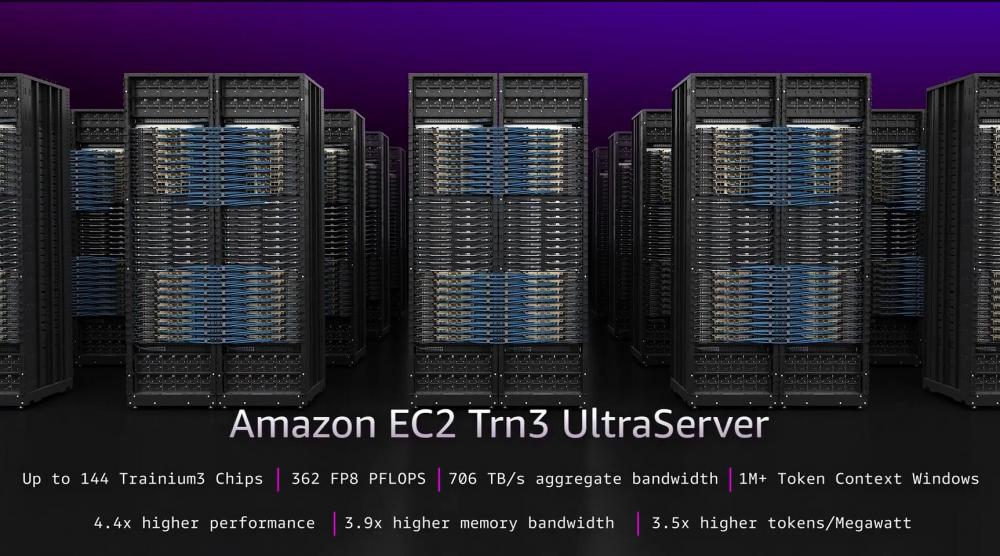

เซิร์ฟเวอร์ Trn3 UltraServer รองรับการใส่ Trainium3 ได้สูงสุด 144 ชิปต่อเครื่อง ให้ประสิทธิภาพรวมประมาณ 362 FP8 PetaFLOPS และสามารถนำไปต่อรวมกันเป็นคลัสเตอร์ขนาดใหญ่แบบ EC2 UltraClusters 3.0 ได้ เครื่องที่ติดตั้ง Trainium3 เต็มทั้งหมดจะมีหน่วยความจำ HBM3E รวมราว 20.7 TB และแบนด์วิดท์รวมราว 706 TB/s พร้อมระบบเชื่อมต่อ NeuronSwitch-v1 fabric ที่ให้แบนด์วิดท์ระหว่างชิปสูงกว่าเดิมถึงสองเท่า AWS ระบุว่าประสิทธิภาพเพิ่มขึ้นอย่างก้าวกระโดดเมื่อเทียบกับ Trainium2 ไม่ว่าจะเป็นประสิทธิภาพโดยรวมที่เพิ่มขึ้น 4.4 เท่า, แบนด์วิดท์หน่วยความจำสูงขึ้น 3.9 เท่า, และประสิทธิภาพต่อวัตต์ดีขึ้นราว 4 เท่า รวมถึงประสิทธิภาพด้าน inference และ token efficiency ที่ดีขึ้นสำหรับบริการของ Amazon หลายรายการ

Amazon ผลิต ASIC เหล่านี้เพื่อช่วยให้ลูกค้าสามารถกระจายโครงสร้างพื้นฐานด้านประมวลผล ไม่ต้องพึ่งพา GPU จาก NVIDIA หรือ AMD เพียงอย่างเดียว บริษัทเองก็ใช้ฮาร์ดแวร์นี้ในการเทรนและให้บริการโมเดลภายใน และยังเปิดให้บางห้องวิจัย AI ชั้นนำใช้งานด้วย Amazon ลงทุนใน Anthropic ไปแล้วเกือบ 8 พันล้านดอลลาร์ ซึ่งก็ใช้ AWS (รวมถึง Trainium2) ในการเทรนและรันโมเดลรุ่นท็อปของตน การมาถึงของ Trainium3 จะช่วยให้ลูกค้าอย่าง Anthropic ได้ประสิทธิภาพสูงขึ้นอย่างมาก และอาจเป็นแรงดึงดูดให้ห้องวิจัยรายใหญ่อื่น ๆ หันมาใช้โครงสร้างพื้นฐานของ AWS มากขึ้นเช่นกัน

ที่มา: TechPowerUp