เร้ดแฮท (Red Hat) ผู้ให้บริการโซลูชันโอเพ่นซอร์สชั้นนำของโลก ประกาศเปิดตัว Red Hat AI 3 ซึ่งเป็นก้าวสำคัญของแพลตฟอร์ม AI ระดับองค์กร ที่ผสานรวมนวัตกรรมล่าสุดของ Red Hat AI Inference Server, Red Hat Enterprise Linux AI (RHEL AI) และ Red Hat OpenShift AI เข้าด้วยกัน เพื่อลดความซับซ้อนของการอนุมาน AI ประสิทธิภาพสูงในการปรับใช้ในระบบขนาดใหญ่(high-performance AI inference) ช่วยให้องค์กรต่าง ๆ สามารถนำเวิร์กโหลดที่อยู่ในขั้นตอนการทดลอง (proofs-of-concept) ไปสู่การใช้งานจริง (production) ได้ง่ายขึ้น และช่วยให้สามารถพัฒนาแอปพลิเคชันที่ใช้ AI ร่วมกันได้อย่างมีประสิทธิภาพมากขึ้น

ในขณะที่องค์กรธุรกิจต่าง ๆ ก้าวผ่านขั้นตอนการทดลองใช้ AI องค์กรเหล่านั้นต้องเผชิญกับอุปสรรคสำคัญหลายประการ ไม่ว่าจะเป็น ความเป็นส่วนตัวของข้อมูล การควบคุมต้นทุน และการจัดการโมเดลที่หลากหลาย รายงาน “The GenAI Divide: State of AI in Business” จากโครงการ NANDA ของสถาบันเทคโนโลยีแมสซาชูเซตส์ (MIT) ย้ำให้เห็นความเป็นจริงของการนำ AI มาใช้งานจริง โดยองค์กรประมาณ 95% ไม่เห็นผลตอบแทนทางการเงินที่วัดผลได้จากการใช้จ่ายขององค์กรประมาณ 40,000 ล้านเหรียญสหรัฐฯ

Red Hat AI 3 มุ่งแก้ไขความท้าทายเหล่านี้ ด้วยการมอบประสบการณ์ที่สอดคล้องและเป็นเอกภาพมากขึ้นให้แก่ผู้บริหารฝ่ายสารสนเทศ (CIO) และผู้นำด้านไอที เพื่อให้ได้ประโยชน์สูงสุดจากการลงทุนในเทคโนโลยีการประมวลผลแบบเร่งความเร็ว (accelerated computing) แพลตฟอร์มนี้ช่วยให้ปรับขนาดและกระจาย AI workloads ไปยังสภาพแวดล้อมไฮบริดที่มีผู้ให้บริการหลายรายได้อย่างรวดเร็ว ในขณะเดียวกันก็ช่วยเพิ่มประสิทธิภาพการทำงานร่วมกันข้ามสายงานที่เกี่ยวกับ AI workloads รุ่นใหม่ ๆ เช่น agent ต่าง ๆ และทั้งหมดนี้ทำงานอยู่บนแพลตฟอร์มหลักเดียวกัน การที่ Red Hat AI 3 มีรากฐานที่สร้างขึ้นบนมาตรฐานแบบ open standards จึงสามารถตอบโจทย์ทุกขั้นตอนของเส้นทางการนำ AI มาใช้ขององค์กร สามารถรองรับโมเดลทุกประเภทที่ทำงานอยู่บน hardware accelerator ใดก็ได้ ตั้งแต่ดาต้าเซ็นเตอร์ ไปจนถึงพับลิคคลาวด์ และสภาพแวดล้อม sovereign AI หรือแม้แต่ edge ที่อยู่ห่างไกล

จาก “การเทรน” สู่ “การนำไปใช้จริง” : การเปลี่ยนผ่านสู่การอนุมาน AI ในระดับองค์กร

เมื่อองค์กรต่าง ๆ เริ่มนำโครงการ AI ต่าง ๆ ไปใช้งานจริง ความสำคัญจึงเปลี่ยนจากการเทรนและปรับแต่งโมเดลไปสู่การอนุมาน (inference) ซึ่งเป็นขั้นตอนของ “การนำไปใช้จริง” AI ในระดับองค์กร Red Hat AI 3 ให้ความสำคัญกับการอนุมานที่สามารถปรับขนาดได้และคุ้มค่าการลงทุน โดยพัฒนาต่อยอดจาก vLLM และ llm-d ซึ่งเป็น community โปรเจกต์ที่ประสบความสำเร็จสูง ควบคู่ไปกับศักยภาพในการเพิ่มประสิทธิภาพโมเดลของ Red Hat เพื่อให้บริการโมเดลภาษาขนาดใหญ่ (LLMs) ในระดับที่พร้อมใช้งานจริง

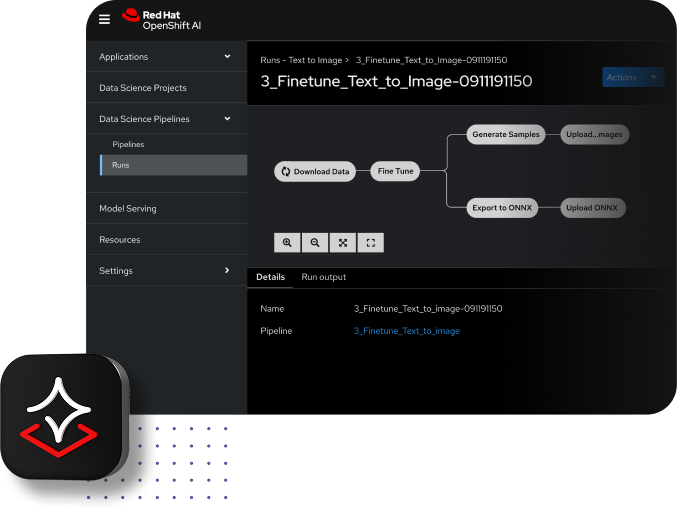

Red Hat OpenShift AI 3.0 เปิดให้ใช้ llm-d ซึ่งเป็นเวอร์ชันพร้อมใช้งานทั่วไปที่พลิกโฉมวิธีการทำงานของ LLM บน Kubernetes โดยเฉพาะ เพื่อช่วยให้ผู้บริหารฝ่ายสารสนเทศใช้งานการเร่งความเร็วด้วยฮาร์ดแวร์ที่มีมูลค่าสูงได้อย่างเต็มประสิทธิภาพ llm-d ช่วยให้เกิดการอนุมานแบบกระจายอัจฉริยะ (intelligent distributed inference) โดยใช้คุุณประโยชน์จากระบบการผสานการทำงานของ Kubernetes และประสิทธิภาพของ vLLM ที่ได้รับการพิสูจน์ประสิทธิภาพแล้ว ผสมผสานกับเทคโนโลยีโอเพ่นซอร์สสำคัญอื่น ๆ เช่น Kubernetes Gateway API Inference Extension, NVIDIA Dynamo (NIXL) KV Transfer Library, และ DeepEP Mixture of Experts (MoE) communication library, ซึ่งช่วยให้องค์กรสามารถ

● ลดต้นทุนและปรับปรุงเวลาในการตอบสนอง ด้วยระบบจัดตารางรันโมเดลแบบ Inference-aware ที่ชาญฉลาด พร้อมระบบให้บริการแบบแยกส่วน (disaggregated serving)

● มอบความเรียบง่ายในการดำเนินงานและความน่าเชื่อถือสูงสุด ด้วยแนวทางที่ชัดเจนและมีมาตรฐาน (Well-lit Paths) ที่ช่วยปรับปรุงขั้นตอนการนำโมเดลไปใช้งานบน Kubernetes ได้อย่างเต็มรูปแบบ

● เพิ่มความยืดหยุ่นสูงสุด ด้วยการรองรับการทำงานข้ามแพลตฟอร์ม (cross-platform support) เพื่อปรับใช้การอนุมาน LLM (LLM inference) กับ hardware accelerators ที่หลากหลาย รวมถึง NVIDIA และ AMD

llm-d สร้างบนพื้นฐานของ vLLM โดยพัฒนาจากเอ็นจิ้นการอนุมานที่มีประสิทธิภาพสูงเริ่มตั้งแต่แบบโหนดเดียว (single-node) ไปจนถึงระบบการให้บริการแบบกระจายศูนย์ (distributed) มีความเสถียร และปรับขนาดได้ ระบบนี้ได้รับการผสานการทำงานกับ Kubernetes อย่างมั่นคง เพื่อมอบประสิทธิภาพที่คาดการณ์ได้ วัดผลตอบแทนจากการลงทุนได้ และการวางแผนโครงสร้างพื้นฐานที่มีประสิทธิภาพ การเพิ่มประสิทธิภาพทั้งหมดนี้ตอบโจทย์การจัดการ LLM workloads ที่มีความผันผวนสูง และการให้บริการโมเดลขนาดใหญ่ เช่น โมเดล Mixture-of-Experts (MoE)

แพลตฟอร์มแบบรวมศูนย์เพื่อการทำงานด้าน AI ร่วมกัน

Red Hat AI 3 มอบประสบการณ์ที่ครบวงจรและยืดหยุ่น ตอบโจทย์ความต้องการด้านการทำงานร่วมกันในการพัฒนาโซลูชัน Generative AI ที่พร้อมใช้งานจริง แพลตฟอร์มนี้ถูกออกแบบมาให้ช่วยส่งเสริมการร่วมมือและการเชื่อมโยงเวิร์กโฟลว์ของทุกทีมไว้ด้วยกันบนแพลตฟอร์มเดียว เพื่อให้วิศวกรแพลตฟอร์ม และวิศวกร AI ขับเคลื่อนกลยุทธ์ด้าน AI อย่างมีประสิทธิภาพ ความสามารถใหม่ที่ออกแบบมาเพื่อเพิ่มประสิทธิภาพและความคล่องตัวในการขยายจากขั้นตอนทดลองแนวคิด (Proof-of-Concept) ไปสู่การใช้งานจริงในระดับองค์กร (Production) ประกอบด้วยความสามารถต่าง ๆ ดังนี้

· Model as a Service (MaaS) ต่อยอดจากเทคโนโลยี distributed inference เพื่อให้องค์กรสามารถเป็นผู้ให้บริการโมเดลของตนเองได้ (self-managed MaaS) โดยให้ทีม IT สามารถให้บริการ โมเดลกลาง (shared models) แก่ทีมพัฒนา AI และแอปพลิเคชันต่าง ๆ ได้แบบ on-demand ผ่านโครงสร้างพื้นฐานภายในองค์กร แนวทางนี้ช่วย บริหารต้นทุนได้ดียิ่งขึ้น และรองรับกรณีการใช้งานที่ ไม่สามารถใช้บริการ AI สาธารณะได้ เนื่องจากข้อจำกัดด้าน ความเป็นส่วนตัวและความปลอดภัยของข้อมูล

· AI hub ช่วยให้วิศวกรแพลตฟอร์มสามารถสำรวจ ติดตั้งใช้งาน และจัดการสินทรัพย์ AI พื้นฐานได้ โดยมีศูนย์กลางที่รวบรวมแคตตาล็อกโมเดลต่าง ๆ ที่คัดสรรให้เลือกใช้ภายในองค์กรซึ่งรวมถึงโมเดล Gen AI ที่ผ่านการปรับแต่งอย่างเหมาะสม, ระบบ Registry เพื่อจัดการไลฟ์ไซเคิลของโมเดล และสภาพแวดล้อมสำหรับการติดตั้งและติดตาม เพื่อกำหนดค่าและตรวจสอบสินทรัพย์ AI ทั้งหมดที่ทำงานอยู่บน OpenShift AI

· Gen AI studio มอบสภาพแวดล้อมที่ให้วิศวกร AI ได้ลงมือปฏิบัติจริงในการโต้ตอบกับโมเดลและสร้างต้นแบบแอปพลิเคชัน Gen AI ใหม่ได้อย่างรวดเร็ว วิศวกรสามารถค้นพบและเรียกใช้งานโมเดลและเซิฟเวอร์ MCP ที่มีอยู่ได้ง่ายขึ้นด้วยคุณสมบัติ AI assets endpoint ซึ่งช่วยให้การเชื่อมต่อระหว่างโมเดลกับเครื่องมือภายนอกระบบเป็นไปอย่างราบรื่น อีกทั้งยังมี playground ในตัวที่เป็นสภาพแวดล้อมเชิงโต้ตอบแบบไร้สถานะ (stateless) เพื่อทดลองโมเดล ทดสอบคำสั่ง (prompts) และปรับแต่งพารามิเตอร์ให้เหมาะสมกับกรณีใช้งาน เช่น chat และการสร้างคำตอบจากข้อมูลที่ดึงมา (Retrieval-Augmented Generation: RAG)

· การพัฒนาทำได้ง่ายขึ้นด้วยโมเดลใหม่ที่ได้รับการตรวจสอบและปรับแต่งจาก Red Hat โดยมีการคัดสรรโมเดลโอเพ่นซอร์สยอดนิยม เช่น gpt-oss ของ OpenAI, DeepSeek-R1 และโมเดลเฉพาะทาง เช่น Whisper สำหรับการแปลงเสียงเป็นข้อความ (speech-to-text) และ Voxtral Mini สำหรับ agents ที่สั่งงานด้วยเสียง (voice-enabled agents)

สร้างรากฐานให้กับ AI agents รุ่นต่อไป

AI agents กำลังจะพลิกโฉมวิธีการสร้างแอปพลิเคชัน และเวิร์กโฟลว์ที่อิสระและซับซ้อนจะสร้างความต้องการสูงต่อความสามารถในการอนุมาน Red Hat OpenShift AI 3.0 วางรากฐานสำหรับระบบ agentic AI ที่สามารถขยายขนาดได้อย่างต่อเนื่อง ซึ่งไม่เพียงแต่ยกระดับความสามารถการอนุมานเท่านั้น แต่ยังมาพร้อมคุณสมบัติและการปรับปรุงใหม่ ๆ ที่เน้นไปที่การจัดการ agent

Red Hat นำเสนอ Unified API layer (เลเยอร์ API แบบรวมศูนย์ ) ที่พัฒนาบน Llama Stack เพื่อเร่งกระบวนการสร้างและปรับใช้ agent ซึ่งช่วยให้การพัฒนาสอดคล้องกับมาตรฐานอุตสาหกรรมต่าง ๆ เช่น โปรโตคอลอินเทอร์เฟซ LLM ที่รองรับกับ OpenAI นอกจากนี้เพื่อส่งเสริมระบบนิเวศที่เปิดกว้างและทำงานร่วมกันได้อย่างยืดหยุ่น Red Hat ยังเป็นหนึ่งในผู้บุกเบิกการใช้งาน Model Context Protocal (MCP) ซึ่งเป็นมาตรฐานใหม่ที่ทรงพลังและกำลังเป็นที่ยอมรับ ช่วยให้การให้การสื่อสารระหว่างโมเดล AI และเครื่องมือภายนอกเป็นไปอย่างมีประสิทธิภาพ ซึ่งเป็นคุณสมบัติพื้นฐานสำหรับ AI agents ที่ทันสมัย

Red Hat AI 3 ยังแนะนำชุดเครื่องมือใหม่สำหรับการปรับแต่งโมเดล ที่ออกแบบให้มีลักษณะเป็นโมดูลาร์และสามารถขยายต่อได้ (modular and extensible toolkit) พัฒนาต่อยอดจากความสามารถของ InstructLab ที่มีอยู่เดิม มาพร้อมไลบราลี Python เฉพาะทางที่ช่วยให้นักพัฒนาสามารถควบคุมและปรับแต่งการทำงานของโมเดลได้อย่างยืดหยุ่นมากขึ้น ชุดเครื่องมือนี้ขับเคลื่อนด้วยโปรเจกต์โอเพ่นซอร์ส เช่น Docling สำหรับการประมวลผลข้อมูล ซึ่งช่วยแปลงและจัดการเอกสารแบบไม่มีโครงสร้าง (unstructured documents) ให้อยู่ในรูปแบบที่ AI สามารถอ่านและประมวลผลได้อย่างคล่องตัว นอกจากนี้ยังมีเฟรมเวิร์กที่ยืดหยุ่นสำหรับการสร้างช้อมูลสังเคราะห์ และ training hub สำหรับการปรับแต่ง LLM (fine-tuning) นอกจากนี้ยังมีการรวม evaluation hub เข้ามาในระบบ เพื่อช่วยให้วิศวกร AI สามารถติดตามและตรวจสอบความถูกต้องของผลลัพธ์ได้อย่างมีประสิทธิภาพ ทำให้สามารถใช้ข้อมูลกรรมสิทธิ์ (proprietary data) ของตนเองได้อย่างมั่นใจ เพื่อให้ได้ผลลัพธ์ AI ที่แม่นยำและตรงความต้องการมากขึ้น

คำกล่าวสนับสนุน

Joe Fernandes, vice president and general manager, AI Business Unit, Red Hat

“เมื่อองค์กรขยายการใช้งาน AI จากขั้นตอนการทดลองไปสู่การใช้งานจริง องค์กรต้องเผชิญกับความซับซ้อน ต้นทุน และความท้าทายใหม่ ๆ ด้านการควบคุม Red Hat ได้ออกแบบ Red Hat AI 3 ให้เป็นโอเพ่นซอร์สระดับองค์กรที่ช่วยลดอุปสรรคเหล่านี้ โดยนำเสนอความสามารถใหม่ เช่น ระบบการอนุมานแบบกระจาย (distributed inference) ผ่าน llm-d และรากฐานสำหรับ agentic AI เพื่อช่วยให้ทีมไอทีสามารถใช้งาน AI รุ่นถัดไปได้อย่างมั่นใจ บนโครงสร้างพื้นฐานรูปแบบใดก็ได้ ตามแนวทางขององค์กร"

Dan McNamara, senior vice president and general manager, Server and Enterprise AI, AMD

"เมื่อ Red Hat นำการอนุมาน AI แบบกระจายเข้าสู่การใช้งานจริง AMD มีความภูมิใจที่ได้เป็นรากฐานประสิทธิภาพสูงที่อยู่เบื้องหลังความสำเร็จนี้ เราได้ผนวกรวมประสิทธิภาพของ AMD EPYC™ processors, ศักยภาพการขยายขนาดของ AMD Instinct™ GPUs, และความเปิดกว้างของซอฟต์แวร์สแตก AMD ROCm™ เข้าไว้ด้วยกัน เพื่อช่วยให้องค์กรก้าวข้ามขีดจำกัดของการทดลองไปสู่การใช้งาน AI เจนเนเรชันใหม่ได้จริง เปลี่ยนประสิทธิภาพและความสามารถในการปรับขนาดให้กลายเป็นผลลัพธ์ทางธุรกิจที่จับต้องได้ทั้งในสภาพแวดล้อมแบบ on-premise, cloud และ edge"

Mariano Greco, chief executive officer, ARSAT

“ARSAT ในฐานะผู้ให้บริการโครงสร้างพื้นฐานการเชื่อมต่อของประเทศอาร์เจนตินา เราต้องจัดการกับปริมาณข้อมูลลูกค้าและข้อมูลที่ละเอียดอ่อนจำนวนมหาศาล เราต้องการโซลูชันที่จะนำพาเราก้าวข้ามระบบอัตโนมัติแบบง่าย ๆ ไปสู่ ‘Augmented Intelligence’ พร้อมกับมอบอำนาจอธิปไตยทางข้อมูลสูงสุดให้กับลูกค้า ด้วยการสร้างแพลตฟอร์ม agentic AI บน Red Hat OpenShift AI เราจึงสามารถระบุความต้องการไปสู่การใช้งานจริงได้ภายในเวลาเพียง 45 วัน Red Hat OpenShift AI ไม่เพียงแต่ช่วยให้เราปรับปรุงบริการและลดเวลาที่วิศวกรต้องใช้ไปกับการแก้ไขปัญหาด้านการสนับสนุน แต่ยังช่วยให้พวกเขามีเวลาไปมุ่งเน้นด้านนวัตกรรมและการพัฒนาสิ่งใหม่ ๆ ได้มากขึ้นอีกด้วย”

Rick Villars, group vice president, Worldwide Research, IDC

“ปีหน้าจะเป็นจุดเปลี่ยนสำคัญ ที่องค์กรจะยกระดับจากการเริ่มต้นการเปลี่ยนแปลงด้าน AI ไปสู่ผลลัพธ์ทางธุรกิจที่สามารถวัดผลและทำซ้ำได้จากการลงทุนใน AI แม้ว่าโครงการเริ่มต้นจะมุ่งเน้นไปที่การเทรนและการทดสอบโมเดล แต่คุณค่าและความท้าทายที่แท้จริงคือการนำข้อมูลเชิงลึกที่ได้มาจากโมเดลไปใช้งานจริงด้วยการอนุมานที่มีประสิทธิภาพ ปลอดภัยและคุ้มค่าใช้จ่าย ซึ่งต้องอาศัยโครงสร้างพื้นฐานยุคใหม่ ข้อมูล และสภาพแวดล้อมการปรับใช้แอปพลิเคชันที่ทันสมัยมากขึ้น พร้อมด้วยความสามารถในการอนุมานระดับการใช้งานจริงที่พร้อมใช้งาน ซึ่งสามารถรับมือกับขนาดและความซับซ้อนในความเป็นจริงได้ โดยเฉพาะอย่างยิ่งเมื่อ agentic AI เพิ่มปริมาณการอนุมาน บริษัทที่ประสบความสำเร็จในการกลายเป็นธุรกิจที่ขับเคลื่อนด้วย AI คือองค์กรที่สามารถสร้างแพลตฟอร์มแบบรวมศูนย์เพื่อจัดการเวิร์กโหลดที่ซับซ้อนมากขึ้นเรื่อย ๆ บนสภาพแวดล้อมไฮบริดคลาวด์ได้อย่างมีประสิทธิภาพ ไม่ใช่เพียงแค่ในโดเมนที่แยกส่วนเท่านั้น”

Ujval Kapasi, vice president, Engineering AI Frameworks, NVIDIA

“การอนุมานที่มีประสิทธิภาพสูงและมีความสามารถในการปรับขนาดได้ถือเป็นกุญแจสำคัญสำหรับ generative และ agentic AI ด้วยการรองรับเทคโนโลยีโอเพนซอร์ส NVIDIA Dynamo และ NIXL Red Hat AI 3 จึงกลายเป็นแพลตฟอร์มแบบรวมศูนย์ที่ช่วยให้ทีมงานสามารถก้าวจากขั้นตอนทดลองไปสู่การรัน AI workloads ขั้นสูง และ agents ในวงกว้างได้อย่างรวดเร็ว”

แหล่งข้อมูลเพิ่มเติม

- เรียนรู้เกี่ยวกับ Red Hat AI 3

- อ่านบล็อกเพิ่มเติมเกี่ยวกับ Red Hat AI 3

- รับฟังฟังเว็บบินาร์ได้ที่ what’s new and what’s next for Red Hat AI

- เรียนรู้เกี่ยวกับ how Red Hat’s ecosystem partners are powering AI innovation

ช่องทางติดต่อเร้ดแฮท

- เรียนรู้เพิ่มเติมเกี่ยวกับ Red Hat

- ข่าวสารต่างๆ Red Hat newsroom

- บล็อก Red Hat blog

เกี่ยวกับเร้ดแฮท

เร้ดแฮท คือผู้นำด้านเทคโนโลยีโอเพ่นไฮบริดคลาวด์ นำเสนอโครงสร้างพื้นฐานที่เชื่อถือได้ สอดคล้อง และครอบคลุม เพื่อรองรับนวัตกรรมด้านไอทีและแอปพลิเคชัน AI ทั้งนี้กลุ่มผลิตภัณฑ์ด้านคลาวด์, ผลิตภัณฑ์สำหรับนักพัฒนาซอฟต์แวร์, AI, Linux, ระบบอัตโนมัติ และแอปพลิเคชันแพลตฟอร์ม ของบริษัทฯ ช่วยให้สามารถใช้งานแอปพลิเคชันต่าง ๆ ได้ทุกที่ ไม่ว่าจะเป็นในดาต้าเซ็นเตอร์ ไปจนถึง edge ในฐานะผู้ให้บริการชั้นนำด้านโซลูชันซอฟต์แวร์โอเพ่นซอร์สสำหรับองค์กร เร้ดแฮทลงทุนด้านระบบนิเวศและชุมชนแบบเปิด เพื่อแก้ไขความท้าทายด้านไอทีที่จะเกิดขึ้นในอนาคต เร้ดแฮทร่วมมือกับพันธมิตรและลูกค้าในการสร้าง เชื่อมต่อ ทำให้เป็นอัตโนมัติ รักษาความปลอดภัย และจัดการสภาพแวดล้อมไอทีให้กับลูกค้าและพันธมิตร โดยได้รับการสนับสนุนจากบริการให้คำปรึกษา รวมถึงบริการการฝึกอบรมและการรับรองที่ได้รับรางวัล

Forward-Looking Statements

Except for the historical information and discussions contained herein, statements contained in this press release may constitute forward-looking statements within the meaning of the Private Securities Litigation Reform Act of 1995. Forward-looking statements are based on the company’s current assumptions regarding future business and financial performance. These statements involve a number of risks, uncertainties and other factors that could cause actual results to differ materially. Any forward-looking statement in this press release speaks only as of the date on which it is made. Except as required by law, the company assumes no obligation to update or revise any forward-looking statements.