SoftBank และ AMD เริ่มทดสอบร่วม พัฒนาโครงสร้างพื้นฐาน AI ยุคถัดไป ด้วยเทคโนโลยีแบ่งทรัพยากร GPU

SoftBank และ AMD ได้เริ่มการทดสอบร่วม (Joint Validation) ของการ์ดเร่งประมวลผล AMD Instinct GPUs สำหรับโครงสร้างพื้นฐาน AI เจเนอเรชันใหม่ โดยมุ่งเน้นไปที่กลไก GPU Partitioning ซึ่งช่วยให้ GPU เพียงตัวเดียวสามารถรองรับงาน AI หลายเวิร์กโหลดได้พร้อมกัน

แนวคิดหลัก: แบ่ง GPU ตาม “ความต้องการของงาน” ไม่ใช่แบ่งเท่ากันหมด

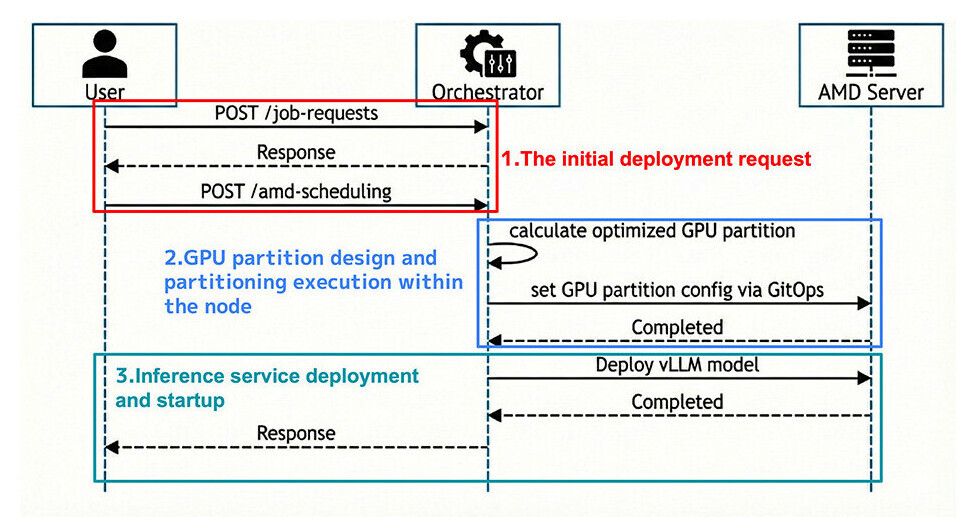

SoftBank ได้พัฒนาระบบควบคุมที่เรียกว่า Orchestrator เพื่อจัดสรรทรัพยากร GPU ตามลักษณะของงาน เช่น

-

ขนาดของโมเดล (Model Size)

-

จำนวนงานที่รันพร้อมกัน (Concurrency)

-

ความต้องการหน่วยความจำ (Memory Requirement)

ระบบจะกระจายงานประมวลผลไปยังหลายอินสแตนซ์ของ GPU ที่ทำงานบน Accelerator Complex Dies (XCDs) แต่ละตัว

โดยสามารถตั้งค่าได้ตั้งแต่:

-

SPX Mode → ใช้เป็นอินสแตนซ์เดียว

-

ไปจนถึง CPX Mode → แบ่งได้สูงสุด 8 อินสแตนซ์ต่อ GPU

นอกจากนี้ หน่วยความจำ HBM ยังถูกแบ่งออกเป็นพูลย่อยเฉพาะของแต่ละอินสแตนซ์ เพื่อป้องกันอาการหน่วง (Latency Spike) จากการแย่งใช้ทรัพยากร

แก้ปัญหาใหญ่ของดาต้าเซ็นเตอร์ AI: ใช้ GPU ไม่คุ้ม

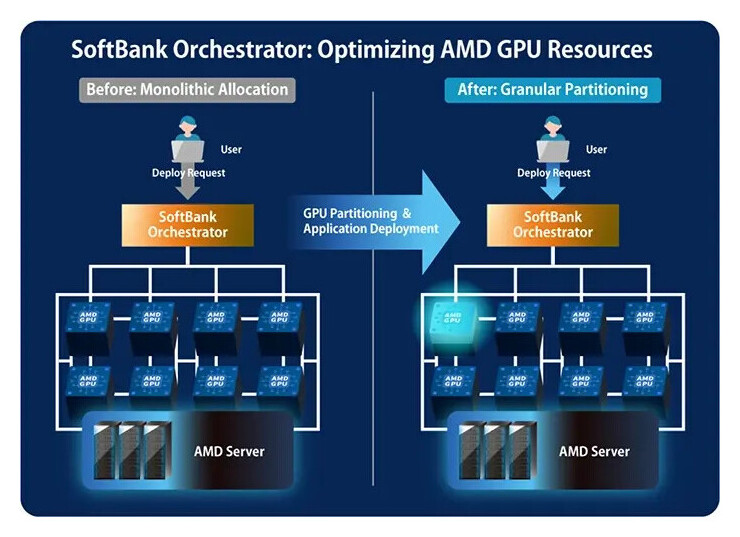

เป้าหมายของแนวทางนี้คือหลีกเลี่ยงการจัดสรร GPU แบบ “ขนาดเดียวใช้ได้กับทุกงาน” (Uniform Allocation)

ซึ่งมักทำให้เกิดปัญหา:

-

บางเวิร์กโหลดใช้ทรัพยากรไม่เต็ม → สิ้นเปลือง

-

บางเวิร์กโหลดทรัพยากรไม่พอ → เกิดคอขวด

SoftBank ระบุว่า Orchestrator รุ่นใหม่นี้สามารถรันแอป AI หลายตัวบน GPU เดียวได้ โดยแทบไม่เพิ่มภาระทรัพยากร และเหมาะอย่างยิ่งกับงาน LLM ขนาดเล็กถึงกลาง

แม้ยังไม่มีการเปิดเผยตัวเลขประสิทธิภาพอย่างเป็นทางการ แต่บริษัทชี้ว่าการจัดสรรทรัพยากรมีประสิทธิภาพดีขึ้นอย่างชัดเจน

เตรียมโชว์จริงในงาน MWC Barcelona 2026

SoftBank มีแผนสาธิตระบบดังกล่าวแบบ Live ที่บูธของ AMD ภายในงาน

MWC Barcelona

ซึ่งจะจัดขึ้นระหว่างวันที่ 2–5 มีนาคม 2026

พร้อมกันนี้ SoftBank ยังเผยแพร่รายละเอียดเชิงสถาปัตยกรรมและวิธีบริหารจัดการ Orchestrator ผ่านบล็อกของสถาบันวิจัยเทคโนโลยีขั้นสูงของบริษัท และมีแผนขยายแนวคิด orchestration ไปยัง AI accelerator จากผู้ผลิตรายอื่นในอนาคตด้วย

อีกด้านของ AMD: โรดแมป Instinct รุ่นใหม่เริ่มสะดุด

รายงานล่าสุดยังระบุว่า accelerator รุ่นถัดไปของ AMD อย่าง Instinct MI455X ซึ่งถูกวางตัวให้แข่งขันกับโซลูชันจาก NVIDIA กำลังเผชิญปัญหาด้านการผลิต

-

ปีนี้คาดว่าจะผลิตได้เพียงจำนวนจำกัด

-

การผลิตจำนวนมาก (Mass Production) ถูกเลื่อนไปเป็น ไตรมาส 2 ปี 2027

ภาพรวม: AI ดาต้าเซ็นเตอร์กำลังเข้าสู่ยุค “Virtualized GPU”

ความร่วมมือนี้สะท้อนแนวโน้มใหม่ของอุตสาหกรรม AI:

อนาคตไม่ได้วัดกันที่ “มี GPU กี่ตัว”

แต่คือ “รีดประสิทธิภาพจาก GPU หนึ่งตัวได้มากแค่ไหน”

โมเดลการแบ่ง GPU ลักษณะนี้กำลังทำให้ทรัพยากร AI มีความยืดหยุ่นใกล้เคียงกับคลาวด์คอมพิวติ้งมากขึ้น และอาจกลายเป็นมาตรฐานใหม่ของ AI Infrastructure ในอีกไม่กี่ปีข้างหน้า.

ที่มา: TechPowerUp