HBM เตรียมก้าวกระโดดครั้งใหญ่! มาตรฐานใหม่ HBM5 และ HBM6 อยู่ระหว่างพัฒนา พร้อมเทคโนโลยี TC Bonder รุ่นใหม่

อุตสาหกรรมหน่วยความจำกำลังเดินหน้าอย่างรวดเร็ว โดยมาตรฐาน HBM5 และ HBM6 เริ่มเข้าสู่กระบวนการพัฒนาแล้ว เพื่อรองรับความต้องการด้าน AI และดาต้าเซ็นเตอร์ที่เพิ่มขึ้นอย่างมหาศาลในอนาคต

บริษัทผู้ผลิตอุปกรณ์เซมิคอนดักเตอร์อย่าง Hanmi Semiconductor ได้เปิดตัว Wide TC Bonder รุ่นแรก ซึ่งถูกออกแบบมาสำหรับการผลิต HBM เจเนอเรชันใหม่โดยเฉพาะ

Wide TC Bonder คืออะไร? ทำไมสำคัญต่อ HBM รุ่นถัดไป

Wide TC Bonder เป็นเครื่องจักรที่ใช้ในกระบวนการเชื่อมชิปแบบ 3D Stacking เพื่อผลิตหน่วยความจำ HBM จำนวนเลเยอร์สูง

โดยถูกพัฒนาขึ้นมาเป็น ทางเลือกแทน Hybrid Bonder (HB) ที่ก่อนหน้านี้ประสบปัญหาทางเทคนิคจนต้องเลื่อนใช้งาน

จุดเด่นของ Wide TC Bonder

-

เพิ่ม Yield การผลิต ให้กับ HBM ทั้งรุ่นปัจจุบันและอนาคต (HBM4 → HBM6)

-

ใช้เทคโนโลยี Fluxless Bonding

→ ลดชั้น Oxide บนผิวชิปโดยไม่ต้องใช้ฟลักซ์

→ เพิ่มความแข็งแรงของการยึดติด

→ ลดความหนาของแพ็กเกจ HBM -

ให้ความแม่นยำสูงกว่า เหมาะกับการ Stack Die จำนวนมาก

ขณะเดียวกัน HBM4 กำลังเข้าสู่ Mass Production

ผู้ผลิต GPU อย่าง NVIDIA และ AMD

เตรียมเปิดตัว AI Accelerator รุ่นใหม่ในปีนี้ โดยใช้หน่วยความจำ HBM4 เป็นหลัก

แต่ด้วยความเร็วของตลาด AI งานพัฒนา HBM5 และ HBM6 จึงเริ่มล่วงหน้าแล้วทันที

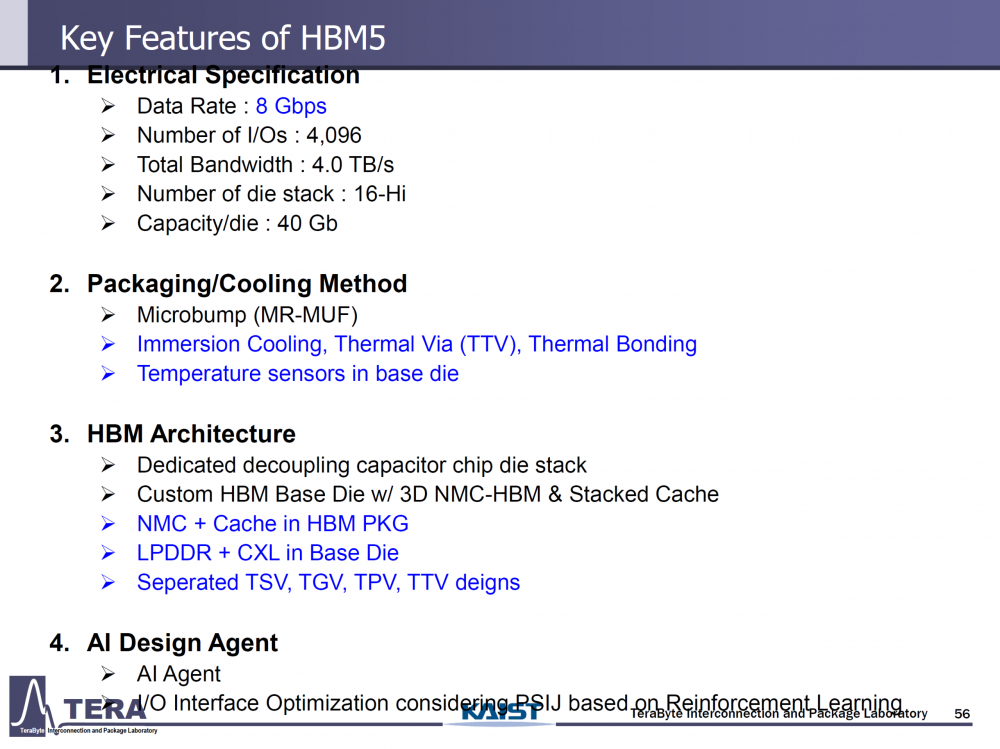

สเปกสำคัญของ HBM5 (คาดใช้งานราวปี 2029)

HBM5 เน้นเพิ่มแบนด์วิดท์และความจุอย่างมาก แม้ Data Rate จะยังใกล้เคียงเดิม

-

Data Rate: 8 Gbps

-

Bus Width: 4096-bit

-

Bandwidth: 4 TB/s ต่อ Stack

-

โครงสร้าง: 16-Hi Stack (มาตรฐานใหม่)

-

ความจุ: 80GB ต่อ Stack

-

ใช้ DRAM Die ขนาด 40Gb

-

กินพลังงาน: ~100W ต่อ Stack

-

Packaging: Microbump (MR-MUF)

-

รองรับ:

-

Immersion Cooling

-

Thermal Via (TTV)

-

Base Die แบบ Custom + Stacked Cache

-

LPDDR + CXL Integration

-

ถูกออกแบบมาสำหรับแพลตฟอร์ม AI รุ่นถัดไปโดยเฉพาะ

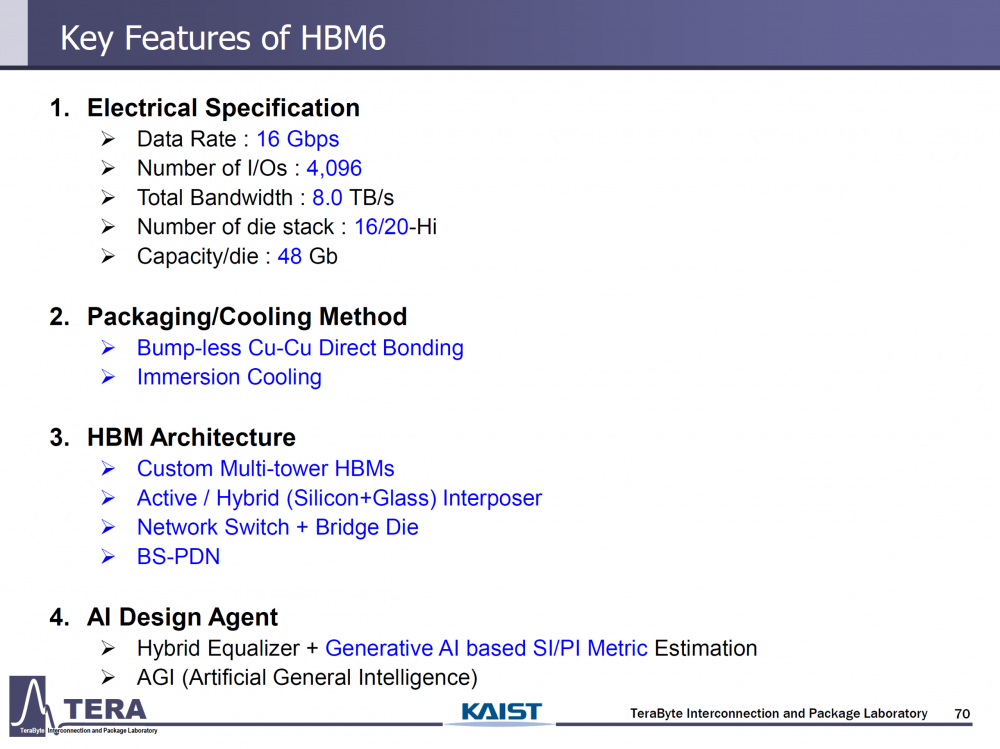

HBM6: ก้าวกระโดดอีกขั้น หลังยุค GPU เจเนอเรชันถัดไป

HBM6 จะเป็นการ “ยกเครื่อง” ครั้งใหญ่ ทั้งด้าน Bandwidth, ความจุ และโครงสร้างแพ็กเกจ

-

Data Rate: 16 Gbps (เพิ่ม 2 เท่า)

-

Bandwidth: 8 TB/s ต่อ Stack

-

Stack สูงสุด: 20-Hi (ครั้งแรกที่เกิน 16 ชั้น)

-

ความจุ: 96GB – 120GB ต่อ Stack

-

DRAM Die: 48Gb

-

ใช้พลังงาน: ~120W ต่อ Stack

-

Packaging: Bump-less Cu-Cu Direct Bonding

-

Cooling: Immersion Cooling เต็มรูปแบบ

เทคโนโลยีใหม่ที่กำลังวิจัย

-

Multi-tower HBM Architecture

-

Active / Hybrid Interposer (Silicon + Glass)

-

Network Switch บนแพ็กเกจ

-

Bridge Die และ Asymmetric TSV

ภาพรวม: ทำไม HBM ต้องพัฒนาเร็วขนาดนี้?

AI Accelerator รุ่นใหม่ต้องการ:

-

แบนด์วิดท์ระดับ TB/s

-

Latency ต่ำมาก

-

หน่วยความจำใกล้ GPU มากที่สุด

-

ความจุสูงระดับ 100GB ต่อ Stack

-

ระบบระบายความร้อนขั้นสุด

HBM จึงกลายเป็น “หัวใจของ AI Infrastructure”

และทุกเจเนอเรชันใหม่กำลังไล่ตามความต้องการของโมเดล AI ที่โตเร็วกว่ากฎของมัวร์เสียอีก

ที่มา: Wccftech